研究内容

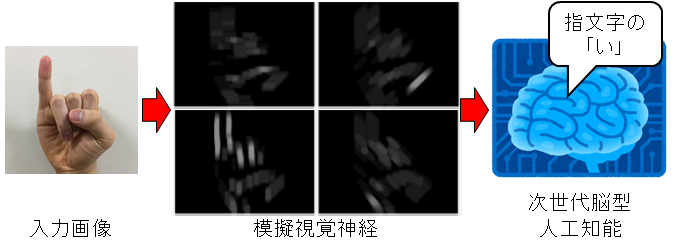

次世代脳型人工知能と視覚神経系の応答特性を活用した画像認識

画像認識は、主に人工知能を用いて精力的に研究されてはいるものの、まだまだ困難なタスクです。対象の形認識に加え、動き認識が加わると、更に難度は飛躍的に上昇します。一方で私達ヒトは、視覚情報から瞬時に形や動きを認識することができ、この能力を活用したコミュニケーション(ジェスチャーや手話)も成立します。

本プロジェクトの目的は、形や動きの抽出を行っている脳内の神経細胞を模倣したアルゴリズムを開発し、これと脳に学んだ人工知能を組み合わせることにより、私達ヒトの様に瞬時に形や動きの認識が出来る、次世代型の視覚認識システムを開発することです。これを利用して、手話通訳装置やジェスチャー解釈装置の実現を目指します。

本プロジェクトで開発している脳型人工知能とディープラーニング等に用いられている従来型人工知能の違いは、人工知能を構成している個々のニューロンが本物のニューロンと同等の時間特性を持ち、本物のニューロンと同等の原理で学習することにあります。これらの特性を生かして、より人間に近い知能の実現を目指します。

小型・高速AIシステムの開発とこれを用いたロボット制御

ディープラーニング等を用いた従来型の画像認識は一定の成功を収めているものの、計算負荷が大きく、スマホやロボットなど非力な小型装置への実装には向きません。一方で、生き物の脳は、コンピュータを構成する半導体よりも遥かに低速な神経細胞から構成されているにも関わらず、難なくリアルタイムで認識を行います。

本プロジェクトの目的は、神経模倣技術と回路設計技術、ディープラーニングの融合により、小型・低消費電力なAIシステムを開発すること、並びに開発したAIシステムを活用して、自律動作可能なロボットを開発することです。

昆虫視覚に学んだ小型飛行ロボットの視覚制御

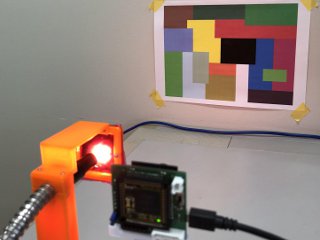

小型飛行ロボットは、人の立ち入りが制限される環境(上の図の様な)において自律的に飛行しながら、作業等を行うことを期待されています。しかし、小型ロボットに搭載可能な大きさと電力で、ロボットの飛行運動を自律制御するシステムを実現することは困難です。一方、飛翔する昆虫たちは、小規模な視覚神経系を駆使して視覚情報を処理することにより、自己状態・飛行距離の把握や衝突回避等の行動を実現しています。

本プロジェクトの目的は、昆虫の視覚神経回路に学び、視覚情報から自己の運動状態や飛行経路、周囲との距離を把握するシステムを開発すること、及びこのシステムを活用して屋内(GPSが利用できない)未知環境を探索する自律飛行ロボットを開発することです。

照明環境に依存しないイメージセンサシステム

視覚情報は、照明光の強さや色に影響を受けるため、従来のロボットビジョンシステムは、大きな光強度変化による視覚情報のロスや照明色変化による視覚情報の変化に苦しんできました。一方、生物の視覚システムは、照明光変化の影響を最小限に抑える様々な優れた仕組みを持っており、生物が幅広い照明環境下で生き抜くのを支えています。

本プロジェクトの目的は、生体視覚系のもつ照明光変化の影響を抑える仕組み(順応、広ダイナミックレンジ符号化、色恒常性)を模倣することにより、過酷な照明変化の下でも安定して視覚情報を提供できるイメージセンサシステムを開発することです。

Copyright © 2016 神経模倣システム研究室 All Rights Reserved.